中信证券:持续看好全球AI领域投资机会,建议聚焦芯片、算力设施、模型架构&工程实践、应用场景等核心环节

ChatGPT在全球AI产业、技术领域带来的良好示范效应,有望推动AI算法模型结束当前的技术路线分叉,并不断向以GPT为主导的大语言模型(LLM)靠拢,加速全球AI产业“工业化”时代到来。中期维度,大语言模型领域“暴力美学”预计仍将是我们不断逼近通用人工智能的最可能路线,基于此基准假设,预计模型算法架构将遵从渐进的学术研究步伐,高质量数据集、工程实践能力、核心人才、资本将成为大模型研发领域的核心竞争壁垒。数据产业链(数据源、数据管理等)、算力设施(大算力芯片、云计算平台、Aiops等)、应用场景(内容生成、人机交互范式、信息检索等)等环节投资逻辑亦面临持续重构。作为中期最具确定性的产业方向之一,我们持续看好全球AI领域的投资机会,并建议持续聚焦芯片、算力设施、模型架构&工程实践、应用场景等核心环节。

▍人工智能:ChatGPT推动产业迎来iPhone时刻,并从“小作坊”走向工业化时代。ChatGPT在全球市场的爆发,正将AI产业推到过去70年以来前所未有的高度,科技巨头纷纷入局,继微软、谷歌之后,国内企业百度、阿里巴巴等先后发布大模型,并进行用户测试和企业应用接入。全球一线科技巨头在AI领域的军备竞赛,以及在大模型方向的持续下注,必将极大加速全球AI产业的发展进程,并推动产业从过去的“小作坊”式发展快速进入“工业化”时代。

▍算法模型:AI发展的灵魂,技术路线料将快速向GPT方向收敛,并有望在中期形成少数大模型(底层) 若干垂类模型(应用层)的格局。ChatGPT的成功证明了高质量数据 反馈激励(大模型预训练 小数据微调)的有效性。GPT在自然语言理解、生成方面的整体优势,有望驱动AI大模型技术路线快速向GPT方向收敛,同时少数科技巨头&机构专注于基础大模型的研发,更多企业则发挥各自在垂类数据、场景理解等层面优势,并最终构建少数大模型 若干应用模型的生态格局。

▍芯片&算力:算法快速迭代,以及对算力的巨大需求,料推动通用AI芯片(GPU)、云厂商早期高确定性受益。目前AI大模型领域的创新正在以月、周为单位快速向前推进,短期维度,预计通用AI芯片仍将是底层算法快速迭代的核心受益者。同时当前大模型在训练、推理环节仍需要巨大的算力承载,云厂商在算力基础设施、基础软件框架等层面综合优势明显,AI带来的算力增量料将主要向云计算平台转移,云厂商有望充分受益。但若后续算法迭代速度放缓,以及针对部分应用场景的专门优化,ASIC芯片需求料将快速展开,AI单位算力成本有望快速下降,但亦同时带来应用需求的进一步增长。

▍数据:AI的粮食和血液。当前AI算法的发展正转向以大模型为主的数据依赖,丰富、高质量数据集是AI产业持续向前的核心基础。伴随公开数据集的逐步耗尽,借助算法实现数据合成,以及垂类领域专有数据集将是企业后续差异化优势主要来源,同时数据使用合规、用户隐私保护等亦将成为持续监管领域。

算法模型:

▍技术路线:以大语言模型为主导,向GPT方案靠拢:ChatGPT的成功证明了GPT模型的Prompting道路的正确性,同时也强调了数据质量的重要性。ChatGPT最重要的成功是在产品化上更进一步:ChatGPT在模型精度上并没有飞跃性的突破,但从Few Shot prompt(需要输入范例示范)转换到Instruct(用人类语言描述想做什么)更加贴合用户的习惯。5)展望未来3-5年的人工智能模型技术路线,我们认为人工智能将继续沿着大语言模型的道路前景发展,并快速向GPT路线收敛。GPT路线已经表现出了其不可替代的产品化能力,这也将推动更多厂商想这个方向投入资源。随着多模态的不断成熟以及新模态的持续加入,我们预计将会看到通用求解能力更强的GPT类基础模型。

▍竞争壁垒:数据质量、资本投入、核心人才、工程实践能力等。1)从Bert开始到GPT-3再到谷歌的PALM,网络中的公开语言数据源已经在被尽可能地利用,而模型的进一步优化对数据质量要求也越来越高。我们认为优质的私有数据源将在未来3-5年里人工智能模型的精度优化上发挥更重要的作用。2)随着模型体量仍然在成倍数增加,大量的前期资本投入是阻碍新入者的重要因素。在过去五年内,我们看到人工智能模型的独角兽都在寻找互联网科技大厂作为其背后的依靠,主要因为能够得到充足而短时间内不求产出的资金支持并获取互联网大厂长期以来所积累的优质数据源。这也是我们看到为什么在过去五年内人工智能头部厂商逐渐从开源走向闭源,利用其资源优势来打造差异化的AI模型,而落后者更希望通过开源的模式以求缩小与头部厂商的距离。3)研发团队的工程能力是决定公司在大语言模型竞争力的另一个重要因素。随着语言模型的体积不断增加,在研究方法上现今千亿量级的模型与之前几十亿量级的小模型发生了本质变化,个体工程师没有能力通过自有资源积累对大模型的学习经验。一个合格的大模型研发团队需要依靠大公司的资源支持才能积累对模型调试、优化、实际部署等各个环节足够的经验。大厂商对大语言模型的底层研究构建了极高竞争壁垒,因此底层架构的研发与实践应用的分离将是必然趋势,前者由少部分大型企业机构主导,而中小型企业专注于后者。

数据:

▍数据:AI的血液与粮食。按照当前LLM的技术范式,数据集主要应用于预训练、模型调优阶段。预训练阶段需要大规模、多类别、高质量的训练数据,在模型调优阶段,垂类小数据集、提示词工程同样重要。近年来全球数据量呈现爆发式增长,据IDC统计,2019年全球产生的数据量为41ZB,过去十年的CAGR接近50%,预计到2025年全球数据量或高达175ZB,2019-2025年仍将维持近30%的复合增速,其中超过80%的数据都将是处理难度较大的文本、图像、音视频等非结构化数据。从Bert开始到GPT-3再到谷歌的PALM,网络中的公开语言数据源已经在被尽可能地利用,但模型优化仍需更多数据,这要求模型开发商有能力接触到优质私有数据来源,从而才能在模型的数据底层取得差异性的优势。

▍数据筛选:为AI提供高质量数据。ChatGPT以GPT 3.5(生成式预训练)模型进行调优,注重数据质量,以及人类反馈强化学习,让模型在早期开放给大众测试并收集人类反馈数据,从而显著增强了模型在海量历史数据中挖掘知识的能力,并最终在人机对话领域获得理想效果。由于不同的行业、不同的业务场景对数据标注的需求存在一定的差异性,高质量的数据集成为提高数据标注质量的关键。公开数据集可以帮助数据标注团队减少从零开始创建和标注大量数据所需的时间和成本,且通常由专业团队或机构创建,其数据质量往往较高。同时,这些通常由专业团队或机构创建,其数据质量往往较高。这有助于提高数据标注项目的准确性和可靠性,从而提高整体项目的质量。根据IDC发布的《2021年中国人工智能基础数据服务市场研究报告》,预计中国AI基础数据服务市场近5年复合年增长率将达到47%,预期2025年将突破120亿元。

▍数据管理:AI产业趋势的核心受益者之一。数据库管理系统是大数据时代的底层软件和核心支撑。AI时代数据量爆发、数据结构复杂度攀升,驱动全球数据库市场长期稳定增长,云化趋势明确。2020年, IDC预计全球DBMS市场规模受疫情冲击小幅降至487亿美元,但云数据库仍然保持11.6%增速。IDC预测2024年全球数据库市场规模将稳步增长至739亿美元,其中云数据库市场规模将达404亿美元,4年CAGR 27.3%。Gartner预测2024年云数据库占比将提升至75%。我们预计2024年中国数据库市场规模达200亿元,同比增长22%且近年来增速不断加快。随着国产化替代的推进,传统海外巨头份额不断缩小。

算力:

▍算力与算法相互促进、相互影响。大模型正在成为人工智能的中短期主流技术路线,随着模型参数日益增多,神经网络算法愈加复杂,相应带来底层算力消耗的持续、显著增长。同时,算力的增长亦为模型参数的增长与复杂性的提高提供基础,算力与算法相互促进,相互影响。

▍算力需求:ChatGPT在工程实践层面的创新推动全球AI领域军备竞赛,并在内容生成领域推动AIGC时代全面到来。1)成本测算方面,我们以英伟达HGX服务器(含8张A100卡)为算力载体并假定服务器成本为8美元/小时,我们测算ChatGPT算力成本约14.6亿美元(其中14.3亿美元为推理成本),生成式AI算力成本约189.6亿美元(训练环节15.4亿美元,推理环节174.2亿美元)。2)AI芯片方面,AI算力的需求增速显著高于摩尔定律的芯片性能增速,芯片设计端需要系统级创新,主要包括制程升级、计算单元数量提升、架构优化、Transformer计算单元的引入、采用混合计算精度等。

▍算力供给:AI芯片的需求增长,吸引全球科技巨头与创业公司加入赛道,硬件设备亦迎来新的需求增量。1)AI芯片:按应用分,AI芯片主要分为AI训练芯片与推理芯片。按技术架构分,AI芯片包括CPU、GPU、FPGA与ASIC,AI服务器正向“CPU XPU”发展。而尽管异构计算正在成为主流,在训练端,GPU仍为主要角色。随着AI产业快速发展,多家公司积极入局,其中不仅包括英伟达、谷歌、亚马逊、华为海思、阿里巴巴、百度等公司在内的科技巨头,还包括Graphcore、Habana(被Intel收购)、寒武纪、地平线等公司在内的初创公司。2)硬件设备:除芯片外,硬件设备亦是算力供应的主要制程,主要包括:①AI服务器:为满足人工智能需求,搭载的XPU数量大幅上升,对AI服务器的散热性与稳定性亦提出更高要求;②交换机&光模块:随着数据量的快速提升,市场对高速、低延时的数据交换需求日益增长,并以此带动交换机与光模块需求,其中800G光模块正在成为行业主流;③算力承载:考虑到AI产业所需的巨大算力,云计算平台为更合理的承载对象。就目前行业情况看,云计算单位成本下降,总算力扩张是大概率事件。

应用场景:

▍AIGC 产业化方向众多、前景广阔。AIGC 在需要高效处理大量客户需求、创意性内容行业以及标准化生产行业均有较大的应用空间,在诸如归纳性文字工作、代码开发相关工作、图象生成领域等领域均有广阔的产业化前景。海内外基于AIGC涌现出诸多应用,如作图领域的Midjourney、文字编辑领域的Notion AI、视频领域的Make-A-Video等。我们认为AIGC的应用方向可分为2C和2B两类:1)ToC 端应用主要包括各类内容生产服务,比如图像生成、语音生成、视频生成、代码生成、文字生成等;2)ToB 端应用主要包括各类融合业务、辅助工作效率类产品,比如:微软使用大模型能力赋能Office、Teams、Dynamics等多种应用场景,Salesforce使用Einstein GPT赋能销售、营销、客服等全场景。

▍实现方式:基于第三方模型进行微调为主流方式,部分厂商通过自研模型构筑壁垒。大语言模型方面,目前主流厂商均选择和OpenAI进行合作,基于自身数据、业务流程等对GPT模型进行微调,在部署上线后亦结合用户数据对Prompting(提示)进行个性化精调,将人类语言的表述根据实际的数据情况更换成更符合大语言模型理解的Prompting,然后以此完成多模态之间的转换并提升指令的准确性。Adobe基于自身在创意领域长年的积累推出了创意生成式人工智能模型Firefly,可以生成图像和文本。一方面,Adobe专注于将其与现有创意流程整合;另一方面,训练数据来自于Adobe Stock的授权内容、公开许可的内容以及版权过期的公共领域内容,以平衡创意生成的需求和内容商业化的可行性。

▍隐私&合规:控制数据及功能访问权限,规避版权等合规风险。数据安全、权限控制、隐私保护、版权合规是大模型在实际应用过程中的核心因素。目前微软在提供copilot相关服务时,在协议中明确表示使用的是公开数据 无版权数据以及微软的自有数据,一定程度降低了数据隐私性的风险。Copilot LLM不会根据用户的自有数据以及用户的提示上进行训练。在企业用户组内部,微软应用了相应的权限模型确保数据不会在用户组之间泄露。而对于Adobe,亦通过规范数据来源,较好地避免了 Stable Diffusion、Midjourney、Dall-E等其他图像生成模型存在的版权合规问题。与此同时,创意者可以选择其作品不进入训练数据集,而Adobe也计划向贡献训练数据的艺术家支付一定报酬。

▍投资建议:

▍风险因素:

AI核心技术发展不及预期风险;科技领域政策监管持续收紧风险;全球宏观经济复苏不及预期风险;宏观经济波动导致欧美企业IT支出不及预期风险;AI潜在伦理、道德、用户隐私风险;企业数据泄露、信息安全风险;行业竞争持续加剧风险等。

本文源自券商研报精选

基金早班车|慧眼识“双五星”牛基 沪深300ETF规模676.68亿元,高居股票ETF规模首位

一、交易提示1.昨日两市3478股上涨,1340股下跌,沪深成交7814亿元。盘面上,电商概念股反弹,军工股全日领涨,机器人概念股、消费电子、算力、虚拟电厂、半导体、电商、电力、培育钻石等股走强。中特估股多数下跌,保险、电信方向全日领跌,医药股、白酒、乘用车、地产、煤炭等股下跌。个股方面,中船防务涨停;中国电信跌4%;欢瑞世纪跌停。北上资金净买入16.87亿元。大财经2023-05-18 22:38:540001无锡停发养老金后续:别拿民心换“政绩”

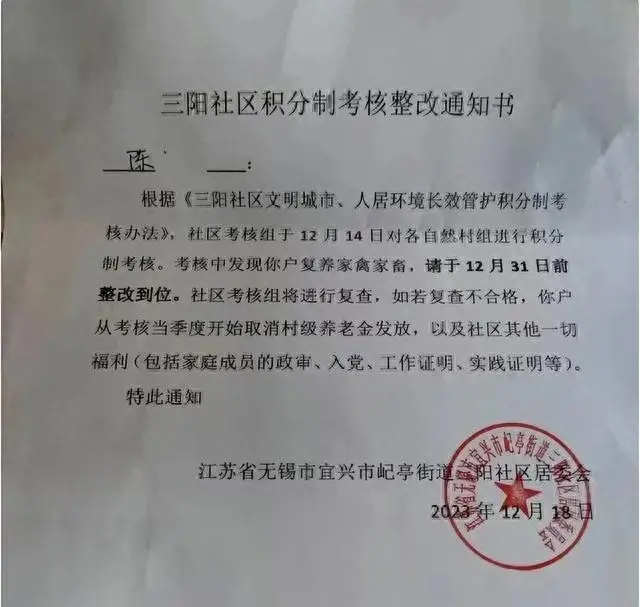

近日,江苏无锡市因一起养老金发放事件引发了社会广泛关注。这不仅仅是一个简单的福利发放问题,更是对地方政府执政理念和能力的严峻考验。面对此事件,我们必须深思:为何会出现这样的情况?为何会引起如此大的社会反响?以及如何避免类似问题的再次发生?大财经2024-01-09 11:24:340000每天认识一个创始人,今天一起来认识一下雅迪电动车创始人...

今天认识一位创始人,他叫董经贵。董经贵的成功源于他善于学习和借鉴他人的长处。今天我们一起来了解一下雅迪电动车创始人董经贵的故事。董经贵出生在安徽省一个贫困的小山村,家里世代都是农民,靠种地为生。董经贵的父母虽然大字不识几个,但对他的教育非常重视。17岁时,董经贵响应国家的号召参军入伍,成为了一名汽车维修兵。这段经历为他后来的创业生涯奠定了基础。大财经2023-11-11 04:39:270001金华升2022年亏损959.37万同比由盈转亏 管理费用大幅增加

挖贝网5月5日,金华升(873386)近日发布2022年年度报告,报告期内公司实现营业收入19,490,231.93元,同比下滑53.16%;归属于挂牌公司股东的净利润-9,593,728.97元,较上年同期由盈转亏。报告期内经营活动产生的现金流量净额为1,922,185.36元,归属于挂牌公司股东的净资产878,377.38元。0001中国上市公司数量第一城:拥有475家,远远甩开深圳、杭州、苏州

上市公司的数量多寡和质量优劣,是一座城市经济发展水平的“风向标”,折射出区域竞争力和营商环境。数量增幅,则反映出该地区的经济活力和发展潜力。过去一年,共有313家企业在境内首发上市,同比减少26.87%。截至2023年底共有上市公司5346家,沪、深、北三大交易所分别为2263、2844、239家。大财经2024-01-09 10:50:470000